(continua)

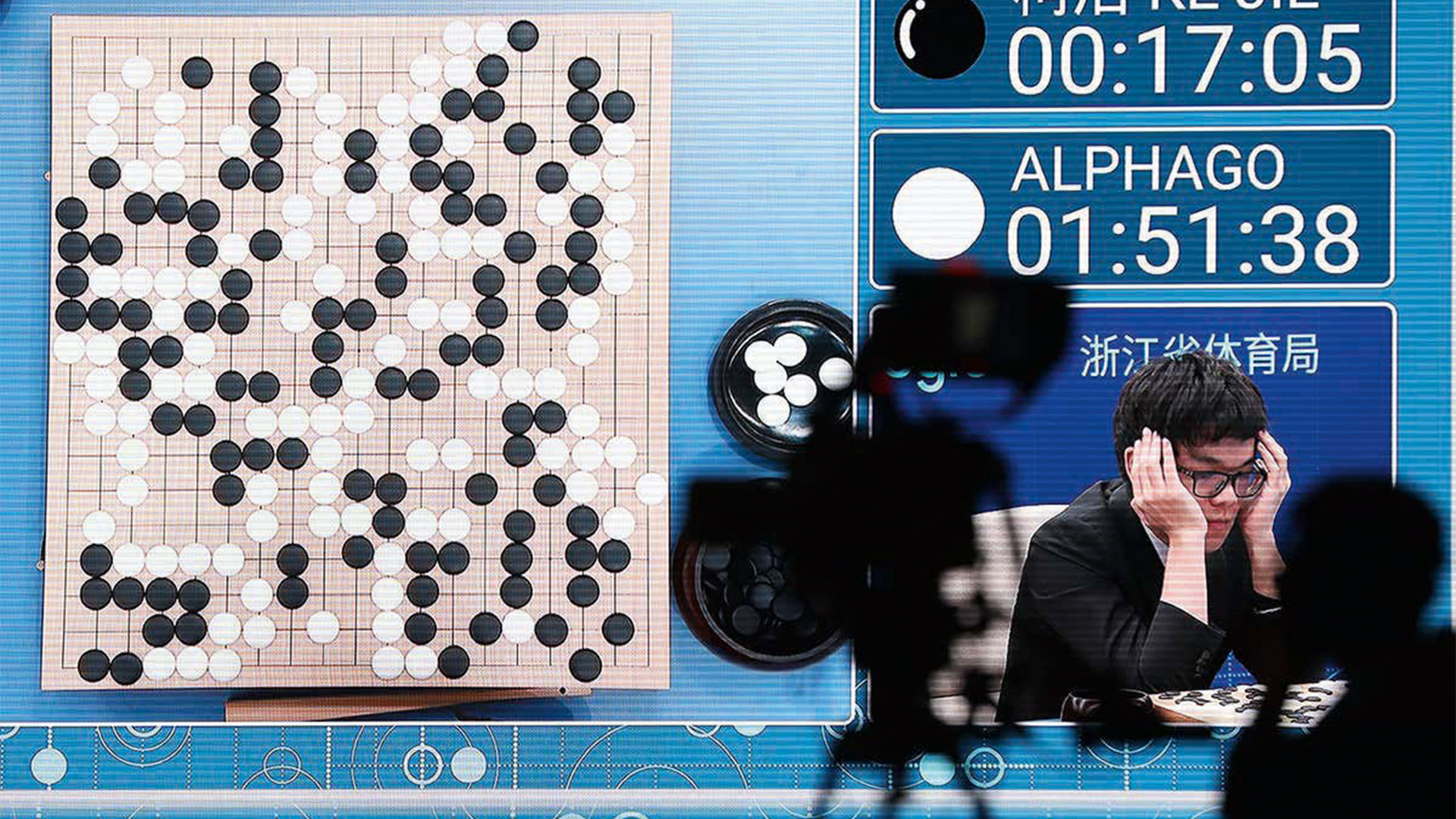

Oggi continuiamo a parlare dell’apprendimento per rinforzo in intelligenza artificiale, in particolare per evidenziare il problema dell’allineamento dei valori tra uomini e macchine. Richiamiamo l’idea dell’apprendimento per rinforzo, di cui abbiamo parlato nello scorso numero: si tratta di fornire alla macchina la capacità di acquisire informazioni sullo stato corrente del mondo, di effettuare un’azione tra le varie disponibili, e di ottenere di un’indicazione numerica su quanto la scelta sia da premiare (o punire). Quest’ultimo aspetto, che dev’essere deciso dall’esperto umano che programma la macchina, è centrale: più azioni vengono fatte, più la macchina utilizza i premi ricevuti per ottimizzare sempre di più sulle scelte fatte, cercando di accumulare il premio totale più alto possibile. Quest’idea è stata ampiamente utilizzata nel contesto dei giochi: è alla base, ad esempio, di alphaGo, il software di google che nel 2015 è stato capace di sconfiggere il campione mondiale di Go (un gioco di strategia che presenta un numero di configurazioni enormemente più elevato degli scacchi, e che non si pensava potesse essere assolutamente alla portata dei computer). Ma cosa c’entra in tutto questo “l’allineamento dei valori”? C’entra perché non sempre quello che l’uomo vuole che la macchina impari coincide davvero con quello che la macchina imparerà davvero: non dimentichiamoci infatti che la macchina non sa davvero cosa voglia l’uomo: semplicemente usa i premi numerici ricevuti per ottimizzare le proprie decisioni. Tra i tanti esempi che ci mostrano quanto sia facile rompere questo allineamento, ne ho scelti due. Il primo: per insegnare a un robot cuoco che per cucinare i pancake bisogna evitare di tenerli troppo in padella, gli viene indicato un premio che è tanto maggiore quanto il pancake sta in aria. Invece di imparare a far saltare spesso il pancake in padella, il robot impara a fare un unico, lancio altissimo. Il secondo: per insegnare a un programma a giocare a un videogioco in modo esplorativo, l’esperto umano lo imposta indicando che qualunque azione faccia non restituirà nessun premio, tranne nel caso in cui l’azione porti al “game over” – in quel caso, il programma riceverà una punizione. Il programma così impostato impara, inaspettatamente, a mettere subito il gioco in pausa: in questo modo, non si raggiungerà mai il “game over”. Sono esempi curiosi, che ci insegnano però quanto è ancora lunga la strada nello sviluppo dell’intelligenza artificiale.

Autore: Marco Montali